China adelanta a Europa en IA con la publicación de una guía ética

El Gobierno de Xi Jinping publica unas directrices para garantizar el despliegue de modelos de IA éticos a lo largo del gigante asiático

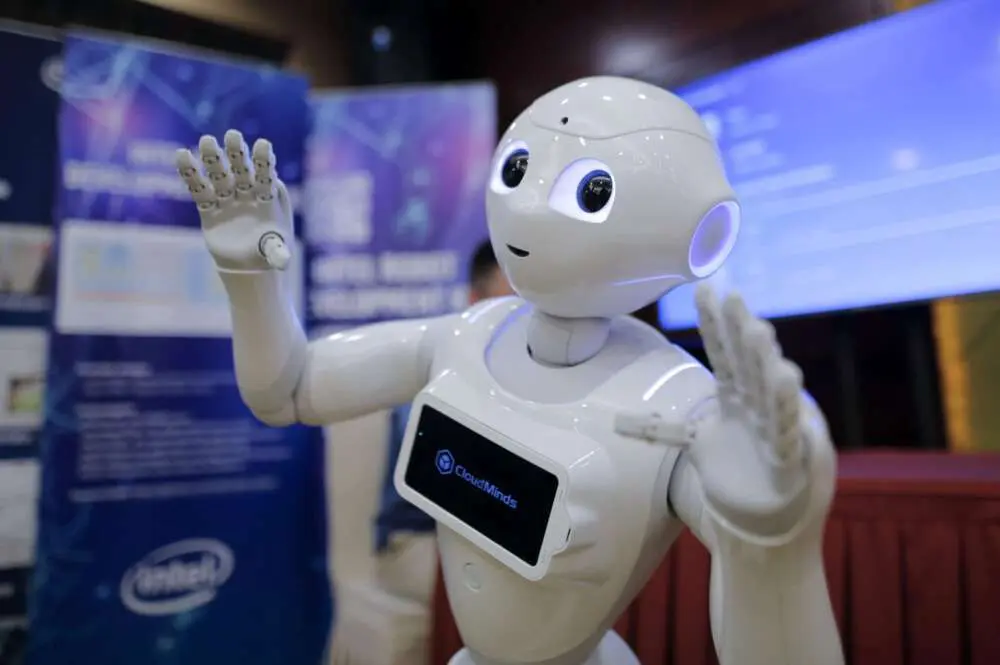

China adelanta a Europa en IA con la publicación de una guía ética./ EFE

El Ministerio de Ciencia y Tecnología chino ha publicado unas directrices éticas con las que regularán los modelos de inteligencia artificial (IA). Los usuarios contarán con plenos derechos para aceptar y rechazar el servicio de una IA, así como para cesar sus interacciones y operaciones a placer con uno de estos sistemas en el momento en el que lo deseen.

De esta manera Pekín se adelanta a la Unión Europea, que lleva meses defendiendo la necesidad de contar con unos desarrollos de la IA que pongan al humano en el centro. La Comisión presentó en abril de este mismo año un borrador para un Reglamento sobre la IA. España se ha propuesto para realizar un piloto de este reglamento, y agentes del sector privado se han postulado ya al mismo.

Según desgrana The South China Morning Post, con las directrices que ha publicado el Gobierno de Xi Jinping los humanos tendrán un «pleno poder de decisión». Este marco ético al que se tendrán que atener los modelos de IA funcionales o en desarrollo también se alinean con los objetivos del gigante asiático: China quiere ser líder en inteligencia artificial para 2030, recuerda el diario.

La premisa de la que parten estas directrices es clara: «Asegurarse que la IA siempre está bajo el control de los seres humanos». Rebecca Arcesati, analista en un think tank alemán llamado Mercator Institute for China Studies, explica en The South China Morning Post que esta es la primera aproximación del gobierno chino hacia la consecución de una IA ética.

«Asegurarse que la IA siempre está bajo el control de los seres humanos»

El documento se ha bautizado como Especificaciones Éticas para Inteligencias Artificiales de Nueva Generación y lo ha publicado, todavía como borrador, una comisión del Ministerio de Ciencia y Tecnología chino que se constituyó en febrero de 2019. En junio de aquel año, esta comisión ya publicó un primer documento con algunas directrices algo más escuetas de las conocidas ahora.

Modelos de IA «controlables» y «fiables»

En seis puntos diferenciados, el nuevo documento del régimen chino enfatizan en la importancia de que los modelos de IA sean «controlables» y «fiables». Otros de los principios mentados en el texto plantean la necesidad de que esta tecnología se emplee para mejorar el bienestar humano, promover la transparencia y la justicia o proteger la privacidad y la seguridad.

Arcesati enfatiza en declaraciones a The South China Morning Postque la publicación de estas directrices es «un claro mensaje» a los gigantes tecnológicos como las estadounidenses Amazon, Facebook o Google. Sobre todo, a aquellas compañías que «han basado su modelo de negocio en algoritmos de recomendación».

Estas directrices también plantea la necesidad de evitar riesgos innecesarios en la aplicación de estas IA garantizando que las mismas no tienen vulnerabilidades ni brechas de seguridad, así como que no se empleen en actividades ilegales o ilícitas que puedan comprometer o «la seguridad nacional» o «el interés general».

Hace escasos días, en un foro de especialistas en sistemas de IA, Gemma Galdon, fundadora y directora de Eticas, nombre que recibe tanto una consultora como una fundación que se dedica a la auditoría algorítmica, hizo algunos apuntes sobre la encrucijada europea y la necesidad de que la Administración Pública cuente con algoritmos éticos.

Mismo software para todos los clientes

En su intervención, Galdon recordaba que uno de los principales desafíos que obstaculizaba el despliegue de sistemas de IA éticos es un fallo de mercado: se intenta escalar el mismo software a todo tipo de cliente. Además, recordaba que el mercado tecnológico sigue orientado a atender consumo, y no a resolver los auténticos problemas sociales.

En esa encrucijada, y frente al modelo de tecnología de consumo que encarna Silicon Valley, Galdon expuso también cuál es la alternativa que se están dando en otros bloques del planeta: el despliegue de sistemas tecnológicos con fines autoritarios, con sistemas de IA diseñados para garantizar grandes plataformas de vigilancia masiva.

Activistas en Europa, entre tanto, siguen demandando a la Unión que prohíban plataformas de vigilancia masiva mediante reconocimiento facial en su futuro Reglamento sobre la IA.

Noticia original: Business Insider

Autor: Alberto R. Aguiar